기술자료실

Gyeongju Smart Media Center

기술자료실

MPEG-V 표준화

MPEG-V 표준과 실감미디어산업 동향

MPEG-V 표준의 필요성

『ICT 표준화 전략맵 Ver. 2015 종합보고서 2 콘텐츠 S/W』의 자료에 따르면 실감형 콘텐츠는 “ICT 기반으로 인간의 감각과 인지를 유발하여 실제와 유사한 경험 및 감성을 확장하는 기술로 정의하며, 오락·문화·방송·교육·의료 등 다양한 분야에서 보고, 듣고, 만지고, 공감하는 체험형 콘텐츠로서 '콘텐츠' 전반의 창작·기획·제작·유통 등에 활용되는 기술을 포함함”이라고 정의. 이러한 관점에서 실감형 콘텐츠 또는 실감미디어의 발전 방향을 살펴보면 [그림 1]과 같이 세 개의 축으로 나누어 볼 수 있고 이는 해상도(Fidelity), 다감각 미디어(Multi-Sense) 그리고 시점(Perspective)으로 나뉨

해상도(Fidelity)

CIF → VGA → SD → FHD → 4K → UHD → 8K → UHD

다감각 미디어(Multi-Sense)

Audio only → (Audio + Video) → (Audio + Video + Other Sense)

시점(Perspective)

Monoscopic → Stereoscopic → Multi-View → Free-View → 3D Holographic

실감 미디어는 시간·공간적 제약 없이 사용자에게 사실적인 느낌을 제공하고, 이를 위해 가상공간에서의 실감효과를 실제 공간의 하드웨어를 통해 실감효과를 실현하고자 하는 노력은 계속되고 있는 실정이며, 이러한 실감효과는 미디어를 청취할 때 시각, 청각, 후각, 미각, 촉각 등의 인간의 오감 정보를 사용자에게 전달하여 마치 사용자가 실제 현장에 있는 것과 같은 느낌을 제공

실감효과를 실현해주는 각각의 하드웨어들은 동일한 효과를 실현한다 하더라도, 하드웨어에 따라 구현 기술과 실현가능한 범위, 실현 방법, 서비스 방법 등이 각자의 하드웨어에 맞도록 국한되어 구현됨. 이는 기술의 발전 속도를 더디게 하며, 실감 미디어 제작 및 활용에 있어서 어려운 문제점 유발됨. 이를 해결하기 위해 MPEG에서는 동영상을 비롯한 가상공간 콘텐츠를 실제 소비 환경과 상호 연동하기 위한 표준으로 2011년 7월 MPEG-V 표준을 최초로 제정되었고, 표준 기술의 도입으로 실감효과 재현기술 개발의 국내외 선두 선점 및 차세대 영상미디어 분야에서의 시장 선점과 기술력 우위를 차지할 수 있는 기대효과가 증대됨

MPEG-V 표준의 구성 및 범위

멀티미디어 콘텐츠에 대한 대표적인 국제표준화 기구인 MPEG(Moving Picture Experts Group)은 MPEG-V(Virtual) 프로젝트 (ISO/IEC 23005)를 통하여 현실세계에서 가상세계, 가상세계에서 현실세계 그리고 가상세계와 가상세계 간 소통을 위한 감각 효과 정보 메타데이터 및 감각 효과 표현 기기 명령어 규격을 정의

The MPEG-V System Architecture

Virtual World

Sensed

SensedInformation

(5)

VW Object

VW ObjectCharateristics

(4)

Sensory

SensoryEffects

(3)

Engine

- R → V Adaption : converts Sensed

Info from RW to VW Object

Char/Sensed Info applied to VW - V → R Adaptation : converts

Sensory Effects from VW into

Device Cmds applied to RW

Sensed

SensedInformation

(5)

Sensory Device

Sensory DeviceCapability

(2)

Real World

(Sensor)

Sensor Adatation

Sensor AdatationPreferences

(2)

User's Sensory

User's SensoryPreferences

(2)

User

Device

DeviceCommands

(2)

Sensory Device

Sensory DeviceCapability

Real World

(Sensory Device)

The numbers (x) refer to the parts of the ISO/IEC 23005 MPEG-V Standard

ISO/IEC 23005에서 명시한 MPEG-V 표준은 총 7개의 파트로 나뉨

- Part1

- Part 1은 아키텍쳐(Architecture)에 대한 내용으로 가상세계와 현실세계 및 가상세계와 가상세계 간 예상되는 인터페이스를 포함한 전체적인 구조와 다양한 예제 시나리오들을 기술

- Part2

- Part 2는 제어 정보(Control Information)에 대한 내용으로 가상세계와 현실세계 간 사이에 적응 엔진(Adaptation Engine)이 존재할 때, 현실세계와 적응 엔진 사이의 인터페이스 구조를 정의

- Part3

- Part 3는 감각 정보(Sensory Information)에 대한 내용으로 사용자의 감각 기관에 영향을 줄 수 있는 감각 효과의 정보를 표현하기 위한 데이터 구조를 기술

- Part4

- Part 4는 가상세계의 객체 특징들(Virtual World Object Characteristics)에 대한 내용으로 가상세계에 존재하는 객체의 모양, 애니메이션, 의사소통 기술, 성격, 제어 등을 표현하기 위한 데이터 구조를 기술함. 이를 이용하여 가상 세계간의 인터페이스를 제공하며, 이를 통해 하나의 가상세계에 존재하는 객체가 다른 가상 세계로 이동하고 생활하는 것이 가능

- Part5

- Part 5는 인터랙션 장치들에 대한 데이터 포맷(Data Formats for Interaction devices)에 대한 내용으로 현실세계와 가상세계와의 연동을 위한 제어 신호 및 센서 정보들에 대한 데이터 구조를 기술

- Part6

- Part 6는 공통 타입과 툴(Common Types and Tools)에 대한 내용으로 MPEG-V 표준 전체에서 공통적으로 사용되는 타입 및 도구들에 대해 기술

- Part7

- Part 7은 참조 소프트웨어(Reference Software)에 대한 내용으로 MPEG-V에서 정의하는 기술들을 실제로 구현하여 사용할 수 있도록 참조 소프트웨어를 구현하여 제공

MPEG-V 표준을 이용한 서비스 시나리오

- V → R

- 가상세계의 실감정보가 현실세계의 사용자 장치로 전송되어 실감효과를 표현하는 경우로서, 이는 가상세계에서 특정 실감효과가 발생했을 때, 현실세계에서 해당 실감효과를 표현하기 위해 매칭된 기기를 통해 사용자에게 동일한 실감효과를 제공함

- R → V

- 현실세계의 사용자의 움직임 및 표정정보 등을 특정 센서를 통해 입력받아 가상세계에 반영하는 경우로서, 이는 현실세계에서 사용자의 움직임에 따라 가상세계의 객체에 특정한 조작을 가할 수 있음

- V ↔ V

- 가상세계와 가상세계 간의 인터페이스에 대한 시나리오가 존재함. 사용자의 개인에 맞도록 제작된 가상 세계의 객체를 서로 다른 가상세계에서 동일하게 사용할 수 도 있을 뿐만 아니라, 두 세계의 각각의 가상객체를 조합하여 새로운 가상 객체를 만들어내는 것 또한 가능함

실감미디어의 성과확산을 위해서는 실감효과 정보, 디바이스 제어 명령, 센싱 정보에 관한 전송 방식 등을 표준화할 필요가 있음

MPEG-V 표준화 진행 및 기술표준화 동향

현재 3rd Edition까지 진행되었고, 2011년 8월 1st Edition IS(International Standard) 문서가 발행됨. 1st Edition에서는 현재 MPEG-V를 구성하는 7개의 파트 중 1~5까지의 파트에 대해 표준화됨. 2nd Edition은 2013년 7월 IS문서가 발행되었으며, 1st에서 정의한 각 파트별 XML 스키마의 Binary 표현, 센서의 적응선호도 및 1st에서 다루지 못한 센서들의 추가가 이루어짐. 마지막으로 2015년 현재 MPEG-V는 3rd Edition DIS(Draft International Standard)까지 진행이 되었으며, 몇 가지 센서들을 추가함. 또한 4th에서 추가될 센서들에 대해서도 별도로 진행이 됨.

최근 MPEG-V는 110차 회의에서 3rd Edition DIS까지 진행되었고, 몇 가지 센서들이 추가된 상황임. 또한 4th Edition에서 추가될 센서들에 대해서도 별도로 진행되고 있음. 현재 3rd Edition에서 Bubble Effect, Proximity Sensor, Switch Sensor, E-Nose Sensor, Automobile-related Sensors, Make-up Avatar와 기존 내용이 변경된 Camera Sensor가 추가됨

오감 감각 효과(실감효과)를 효율적으로 전달할 수 있는 매개체 및 방법에 대한 R&D가 필요함

표준화된 오감 감각 효과의 미디어 표현 방식에 따라 테스트베드 구축 검토 필요

산업화 동향

MPEG-V 표준화 작업은 ETRI에서 주도하고 있고, 2011년 국제표준으로 제정된 후 멀티미디어 기술의 발전과 함께 실감미디어산업에서의 MPEG-V 표준 관련 기술은 미래의 고부가가치 산업으로 전망함. 특히, 실감미디어산업은 방송, 영화, 콘텐츠, 기기제조업체와의 연계를 통한 서비스 창출로 관련 산업과의 고부가가치 실현을 통한 동반 성장이 가능하며, 특히 차세대 성장동력과 연계한 산업간 파급효과가 매우 클 것으로 예측되고 있음

MPEG-V 표준화에 따른 가상세계 발전 전망은 현실세계와 가상세계의 구분없이 가상세계에서 가상세계로의 객체에 대한 표현과 행동이 자유로운 형식으로 현재의 스마트폰과 같이 사람의 일상생활에 자연적으로 적용될 전망

미래창조과학부의 K-ICT전략에 따른 융복합 산업의 발전과 함께 MPEG-V 표준 기반의 실감효과 재현장치들을 이용하여 사람의 감성 인터렉션을 이용한 실감 휘트니스, 실감 의료정보, VR과 AR이 적용된 실감체험 교육, 실감엔터테인먼트 산업 분야가 발전할 것으로 전망되고 실감미디어 성과확산사업단에서는 이러한 유망 산업 분야에 대해 이기종 실감효과 재현장치에 대한 MPEG-V 표준 기반의 실감효과 재현 컨트롤러 개발과 구축 및 4K UHD급 360° VR 또는 AR, 홀로그램이 적용된 다양한 형태의 실감콘텐츠의 제작과 기존 콘텐츠의 리뉴얼을 통한 실감콘텐츠의 재생산을 통해 종합 유통망 체계인 실감HUB를 운영할 계획임. 또한, 지역의 유망 중소기업들과의 연계를 통한 MPEG-V 표준 기반의 실감효과 재현 장치 및 기술들의 선점에 우위를 차지하여 지역 경제를 이끌어갈 수 있도록 추진 중

MPEG-V 표준기술 개발 사례

실감효과 저작도구

실감효과 저작도구는 3차년도 실감미디어산업 성과확산사업에서 기수행한 “MPEG-V 표준 기반 실감미디어 저작솔루션 구축 사업”의 개발 결과물로 도출된 소프트웨어로서 MPEG-V 표준에 정의된 15종의 실감효과 중 10종의 실감효과를 저작할 수 있는 소프트웨어와 실감효과를 자동으로 추출할 수 있는 소프트웨어로 구분된다. 모든 소프트웨어는 MPEG-V 표준(ISO/IEC 23005)에 기반을 두어 제작된 것으로 향 후 실감미디어산업군내 실감효과 재현기술의 표준화에 따른 우리나라의 실감효과 재현 기술의 선점과 디지털 미디어 산업의 기술 선점을 위한 중요한 기술 개발 결과물이라 사료 된다. 아울러 기존의 실감효과 저작도구의 경우 특정한 SFX환경에서만 운용이 가능하기 때문에 제작된 결과물에 대한 활용성이 매우 떨어졌으나 MPEG-V 표준에 기반을 둔 실감효과 저작도구의 경우 표준 환경이 조성된 환경에서 언제 어디서나 운용이 가능하기 때문에 제작된 결과물에 대한 확장성과 가치가 매우 높아 실감미디어 산업 전반에 널리 활용이 가능하다.

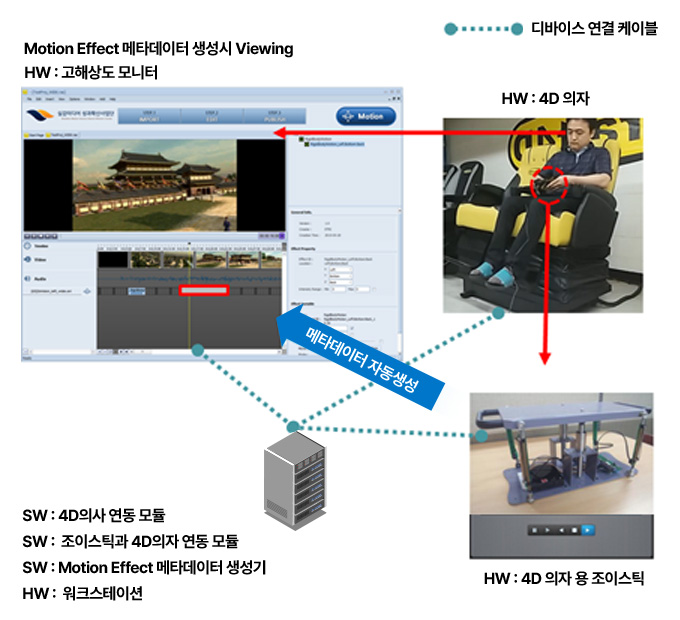

MPEG-V표준 기반 실감미디어 저작 솔루션 구축

- MPEG-V 표준 Motion Effect 입력 및 생성 시스템

- MPEG-V 표준 Light Elect 입력 및 생성 시스템

- MPEG-V 표준 Rasch Bflect 입력 및 생성 시스템

- MPEG-V 표준 Temperature Elect 입력 및 생성 시스템

- MPEG-V 표준 Wind Bled 입력 및 생성 시스템

- MPEG-V 표준 Vibration Effect 입력 및 생성 시스템

- MPEG-V 표준 Spraying Effect 입력 및 생성 시스템

- MPEG-V 표준 Fog Effect 입력 및 생성 시스템

- MPEG-V 표준 Saert Effect 입력 및 생성 시스템

- MPEG-V 표준 Bubble Effect 입력 및 생성 시스템

- 미디어 기반 MPEG-V 표준 Effect 자동추출 시스템

SoftWare: Effect 키패드 연동 모듈

Motion/light/Flash/Temperature/Wind/

Vibraion/Spraying/Fog/Scent/Bubble

SoftWare: Effect 메타데이터 생성기

Motion/light/Flash/Temperature/Wind/

Vibraion/Spraying/Fog/Scent/Bubble

- 미디어 기반 MPEGV 표준 실감콘텐츠 저작프로그램

- 이벤트 기반 MPEGV 표준 실감콘텐츠 저작프로그램

- MPEGV 표준 실감콘텐츠 워크스테이션 기반 시뮬레이터

- MPEG-V 표준 실감콘텐츠 KOS 기반 시뮬레이터

- MPEG-V 표준 실감콘텐츠 Android 기반 시뮬레이터

SoftWare

실감미디어 저작도구

SoftWare

실감미디어 시뮬레이터

HardWare : 워크스테이션

HardWare : 오감체험 실감 디바이스

실감효과 저작도구는 크게 2가지로 나뉜다.

REAL 4D EMAKER

- ‘REAL 4D EMAKER’는 MPEG-V 표준에 정의된 10종의 실감효과(Rigid Body Motion, Light, Flash, Temperature, Wind, Vibration, Spraying, Fog, Scent, Bubble)에 대해 각각의 실감효과를 입력하고 생성할 수 있는 소프트웨어이다. 전문적으로 실감효과를 입히는 기업 또는 전문가가 사용하는 도구로서 태블릿을 이용한 입력태깅 기능과 이를 수정 및 보완할 수 있는 기능 그리고 시뮬레이션을 수행해볼 수 있는 기능이 탑재되어 있다. 또한, ‘REAL 4D EMAKER’는 미디어 정보에 따라 실감효과 메타데이터를 입력하는 소프트웨어로서 미디어 영상의 분석을 통한 시간별 대표 프레임 추출과 저장, 미디어 타임라인 별 실감효과 입력 및 생성 기능, 프레임 정보 타임라인 간의 연동 기능 등을 제공한다. 특히, Rigid Body Motion 실감효과에 대한 입력 소프트웨어의 경우 특수하게 제작된 모션 입력장치를 통해 입력자가 의도한 형태의 실감효과를 손쉽게 입력할 수 있도록 고안되어 기존의 입력장치로 제한적으로 입력 및 생성했던 것과 달리 사용자 친화적인 입력이 가능한 소프트웨어다.

REAL 4D STUDIO

- ‘REAL 4D STUDIO’는 MPEG-V 표준에 정의된 10종의 실감효과(Rigid Body Motion, Light, Flash, Temperature, Wind, Vibration, Spraying, Fog, Scent, Bubble)에 대해 실감효과를 저작할 수 있는 소프트웨어이다. ‘REAL 4D EMAKER’와 달리 미디어 뿐만 아니라 다양한 환경에 적용이 가능하도록 이벤트 기반의 실감효과도 저작이 가능하고, 제작한 실감효과에 대한 3D 가상시뮬레이션을 통해 자신이 입력한 실감효과의 결과물을 확인해볼 수 있는 기능이 제공된다. 또한, 미디어/이벤트 기반의 실감 프로젝트 관리, 미디어 정보 기반 타임 라인 설정과 컨트롤, 미디어/이벤트 기반의 실감효과 퍼블리싱, Rigid Body Motion에 특화된 사용자 입력 UI/UX를 제공하며, 기존의 다양한 조이스틱 컨트롤러를 통해 Motion 실감효과의 입력이 가능하도록 구축되어 있다. ‘REAL 4D EMAKER’는 주로 전문적인 실감효과의 입력을 위해 사용되었으나 ‘REAL 4D STUDIO’의 경우 일반인들도 손쉽게 사용이 가능하도록 제작되었다.

또한, 사용용도에 따라 전문가용 버전과 학생용(교육용) 버전으로 나뉘고, 전문가용(유료버전)의 경우 10종의 실감효과에 대한 저작과 시뮬레이션이 가능하지만, 학생용(무료버전)의 경우 5종의 실감효과(Motion, Wind, Fog, Bubble, Flash)만 저작이 가능하고, 시뮬레이션 기능이 제외되어 있다. ‘REAL 4D STUDIO’의 경우 다음의 사이트에서 다운로드가 가능하고, 전문가용 버전을 사용하기 위해서는 실감미디어 성과확산사업단과의 협의를 통해 사용이 가능하다.

REAL 4D STUDIO 다운로드 사이트 : http://cast.real4dhub.or.kr/about/authoring/download

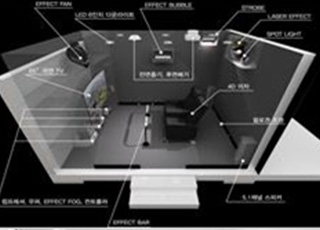

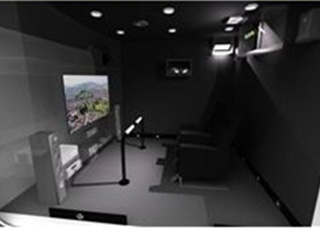

텔레포팅(체험부스) 시스템

- 텔레포팅(체험부스) 시스템은 3/4차년도 실감미디어산업 성과확산사업에서 기수행한 “인터넷기반 공공서비스 실감미디어 시험시스템 구축 및 시제품 제작 사업” 및 “박스형/오픈형 텔레포팅(체험부스) 시스템 도입 사업”의 결과물로 도출된 것이다. 기존의 실감미디어 체험은 4D영화관 또는 표준 규격이 아닌 소형 시뮬레이터를 이용한 것이 대부분이었기 때문에 문화유산 또는 재난재해 체험 등의 교육적인 체험 등의 특수 목적을 둔 콘텐츠 혹은 4D체험관이 없는 지역의 경우 체험을 할 수 없었다. 이를 위해 이동이 가능한 실감미디어 체험부스를 제작하여 언제어디서든 사용자의 요청에 따라 다양한 콘텐츠를 실감효과 재현과 함께 즐길 수 있는 시스템의 프로토타입을 구축하여 2015년 8월 21일부터 59일간 경주세계문화엑스포공원 문화센터 내에서 시연을 했고, 9천명에 가까운 사람들이 체험부스 시설을 방문 및 관람했다. 아울러 이를 개량한 형태의 박스형과 오픈형 타입의 텔레포팅(체험부스) 시스템 구축하여 유관기관 또는 사용자들의 수요와 요청이 있을 경우 시스템을 이동하여 다양한 형태의 콘텐츠를 체험할 수 있도록 했다. 텔레포팅(체험부스) 시스템은 아래의 그림과 같이 박스형과 오픈형으로 나뉜다. 박스형의 경우 64인치 커브드 TV와 8종의 실감효과 재현 장비(Motion Chair, Wind, Flash, AirJet, Bubble, Laser, Fog)를 이용한 DID형 체험부스이고, 오픈형의 경우 오큘러스 리프트와 Motion Chair를 이용한 HMD형 체험부스이다.